5/14일 새벽2시, OpenAI가 라이브 방송으로 GPT-4o 모델을 공개했습니다.

이 최신 모델은 기존 GPT 4의 지능을 갖고 있지만 응답속도가 훨씬 빠르며

텍스트, 음성 뿐만 아니라 실시간 영상을 인식해서 처리할 수 있습니다.

(한국어 처리 능력도 1.7배 적은 토큰을 사용하도록 개선되었다고 하네요)

아래는 OpenAI 사이트에 공개된 소개 자료를 GPT-4o 모델로 번역한 것입니다.

(다섯줄 요약)

- GPT-4o는 실용성을 목표로 한 최신 딥러닝 모델로, 효율성을 개선하여 널리 제공됩니다.

- 오늘부터 ChatGPT에서 텍스트 및 이미지 기능을 롤아웃하며, 무료 등급과 Plus 사용자에게 최대 5배 더 높은 메시지 한도를 제공합니다.

- 몇 주 안에 ChatGPT Plus에 새로운 음성 모드가 알파 버전으로 롤아웃될 예정입니다.

- 개발자들은 이제 GPT-4o에 API를 통해 접근할 수 있으며, GPT-4 Turbo보다 2배 빠르고 가격은 절반, 속도 제한은 5배 더 높습니다.

- 몇 주 안에 소수의 신뢰할 수 있는 파트너에게 API를 통해 오디오 및 비디오 기능 지원을 시작할 계획입니다.

아래는 금일 발표된 영상 일부와 내용 설명입니다.

보이스 모드 엄청 발전했다

음성 보내고 답변 받는게 아니라

실제로 대화하듯이 실시간으로 답변해줌

그리고 답변하는 목소리에 감정이 담김

진짜 사람마냥 농담도 익살스러운 목소리로 하고

걱정하는 목소리나 진정시키는 목소리, 웃는 목소리 톤 등 감정을 실는게 가능해짐

그리고 카메라로 뭔가 찍어서 보여주고 그 장면에 대한 피드백을 받을 수 있음

발표에서는 종이에다가 수식 적어놓고 어떻게 풀어야하는지 도움 받는거 보여줬는데 종이에 쓴 글도 잘 인식하고 종이에 뭔가 새로 뭐 적으면 즉각즉각 피드백 해주더라고

그리고 컴퓨터 화면도 보여주면서 소통 가능함

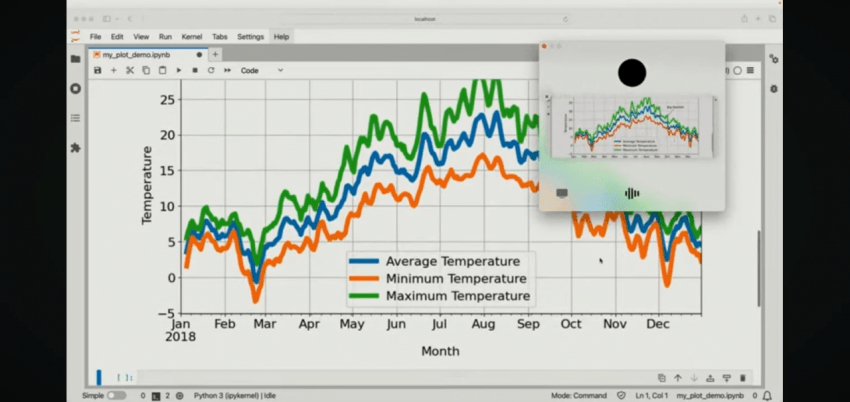

그리고 이런식으로 그래프 보여주면서 질문하니 그래프가 뭐에 대한건지 정확하게 이해하고 설명해줬고

기온이 가장 높은 시기가 언제인지 물어보니 정확하게 답변해줌

그리고 번역 기능도 뛰어난듯

발표에 나온 남자는 영어로 말하고 여자가 이탈리어로 말하면 영어는 이탈리아어로, 이탈리아어는 영어로 번역해 달라고 하니 진짜 통역사처럼 상대 말을 번역해서 전해주더라

그리고 이런식으로 카메라로 얼굴 보여주면 표정으로 기분도 유추해냄

영상통화처럼 실시간으로 대화하며, 주변에 삼각대, 조명이 있다는 것을 보고 동영상이나 라이브 중이냐고 묻고

사용자가 발표를 할 것이라고 하자, 장비들의 수준, 사용자가 오픈ai로고가 박힌 옷을 입고 있다는 점을 통하여

openai와 관련된 꽤 전문적인 발표임을 유추하는 영상.

휴대폰 카메라를 통해 실시간으로 강아지를 인식하며 풍부한 감정을 담은 대화를 할 수 있습니다.

화상채팅을 하는 4명의 인간과 한 명(?)의 AI입니다.

레이턴시 없이 자연스럽고 부드러운 대화를 이어가는데 목소리에 대한 칭찬과 회의 내용 요약이 돋보입니다.

2명(?)의 AI가 서로 대화를 하고 나중엔 노래를 한소절씩 나눠부릅니다.

중간에 다른 직원이 난입해서 장난을 치는데 AI가 모른척하다가 뭔가 특이한거 없었냐 물어보니 그제서야 봤다고 대답합니다.

https://www.youtube.com/playlist?list=PLOXw6I10VTv8VOvPNVQ8c4D4NyMRMotXh

시연영상 총 16개 플레이리스트

실시간 음성채팅에서 말하는 도중 말끊고 개입해도 듣고&답변 가능에

실시간 2개국 사용자들에게 양방향 통역해주고,

노래도 부르고 동화 스토리도 만들어서 들려주고

이 모든게 매우 빠름... 그냥 영화 HER나 아이언맨 자비스랑 똑같음

- 개쩌는 오픈AI, GPT-4o 음성 모델 영상 모음

오디오, 비전, 텍스트를 실시간으로 추론할 수 있는 새로운 플래그십 모델인 GPT-4o를 발표합니다.

GPT-4o("옴니"를 의미하는 "o")는 훨씬 더 자연스러운 인간-컴퓨터 상호 작용을 향한 한 단계입니다.

텍스트, 오디오 및 이미지의 모든 조합을 입력으로 받아들이고 텍스트, 오디오 및 이미지 출력의 조합을 생성합니다.

0.23초 안에 오디오 입력에 응답할 수 있으며, 이는 평균 0.32초인 인간의 응답 시간 과 비슷합니다.

대화 중. 영어 및 코드 텍스트의 GPT-4 Turbo 성능과 일치하며, 영어가 아닌 언어의 텍스트에 대한 상당한 개선이 이루어지며, API에서는 훨씬 빠르고 비용이 50% 더 저렴합니다. GPT-4o는 특히 기존 모델에 비해 시각 및 청각 이해도가 더 뛰어납니다.

/////진짜 지린다... 영화 HER가 현실이 되었다. 물론 호들갑일 수도 있지만, GPT-4o니까 여름에 나올 GPT-5 그리고 다음 세대까지 생각하면 그냥 코앞에 다가왔다고 봐야 맞을듯.

추가로 휴메인 AI PIN도 약간 소생각이 보였다. 폰을 항상 들고다니며 카메라로 주변을 인식 시켜 상호작용 하는건 손도 불편하고 폰 써야할땐 잠시 기능을 사용할 수 없는 문제도 있으니 그냥 옷에 붙여놓고 다니는 AI PIN이 유용할지도 모르겠음. 마침 카메라도 달려있으니까. 특히 시각장애인들한테 유용할 거 같아.

얘가 쫄딱 망한게 비싼 기기비용, 매월 나가는 통신비 + 그냥 깡통 GPT-4 API를 써서 응답 속도도 느리고 말귀도 못알아듣고 멍청한 게 한몫했는데 이번 기능 AI PIN에 들어오면 성능 확 뛰어오르겠네...물론 1세대 모델이라 흥하긴 힘들겠지만 누군가는 유용하게 쓸지도

- gpt4o 이미지 인식 미쳤네 ㅋㅋㅋㅋ

- 오픈AI, 'GPT-4o'(지피티-포오) 공개

댓글 영역

획득법

① NFT 발행

작성한 게시물을 NFT로 발행하면 일주일 동안 사용할 수 있습니다. (최초 1회)

② NFT 구매

다른 이용자의 NFT를 구매하면 한 달 동안 사용할 수 있습니다. (구매 시마다 갱신)

사용법

디시콘에서지갑연결시 바로 사용 가능합니다.